El lado oscuro de la fuerza es un camino a muchas habilidades, algunas consideradas antinaturales”, le decía antes de convertirse en emperador galáctico el Canciller Palpatine al joven Anakin Skywalker. Sin embargo, “Un misterio infinito la Fuerza es”, según el maestro Yoda. Pues con la Inteligencia Artificial pasa algo parecido.

Si las nuevas herramientas como el revolucionario ChatGPT están cambiando las reglas del juego en cuanto a búsqueda de información, desarrollo de proyectos y agilidad computacional, sus enormes posibilidades también han atraído el interés de hackers y ciberdelincuentes. Por ventura o por desgracia, la IA es como la Fuerza de Star Wars y, siempre que hay un avance tecnológico, surge un lado oscuro que intenta sacar provecho de él.

Es cierto que, en principio, la herramienta de OpenAI está programada para negarse a crear malware, pero ya ha habido experimentos más o menos exitosos en que se ha conseguido ‘engañarla’ para manipularla de forma que permita crear u ofrecer información que permita acceder a información sensible, a producir contenidos inapropiados o a ejecutar códigos maliciosos.

La compañía, desde luego, es consciente de los riesgos, está comprometida con la seguridad y no deja de investigar: “Nuestro trabajo para crear una IA segura y beneficiosa requiere un profundo entendimiento de sus potenciales riesgos y beneficios, así como una cuidadosa consideración sobre su impacto”, afirman. Como ella, también el resto de grandes tecnológicas, como Google AI o Bing, todas ellas invirtiendo grandes sumas en el desarrollo de este tipo de aplicaciones, defienden las enormes posibilidades de esta tecnología y se comprometen a vigilar sus posibles riesgos y calmar a todos aquellos que piensan que ‘acabará con la raza humana’.

Así que el problema no son tanto las aplicaciones legítimas como sus primas hermanas, algo más oscuras. Sería la inteligencia artificial ‘mala’, sin límites éticos o, más bien, programada por quienes no los tienen.

La más conocida hasta la fecha es WormGPT, un modelo de GPT –generative pre-training transformer– especialmente diseñado para el mal. “No nos extraña la velocidad a la que han surgido y se han hecho conocidas este tipo de herramientas maliciosas, era cuestión de tiempo y ha sido rápido”, explica Lambert Global Consumer Operations Manager de Panda Security. “La principal diferencia con el modelo original es que aquí sí se pueden crear -o más bien solicitar la creación – códigos maliciosos, ya que se trata de herramientas no está reguladas y sin los filtros de seguridad pertinentes”, afirma.

Según un informe de la empresa internacional de ciberseguridad Slash Next, una de las primeras en alertar sobre ello, este WormGPT (que es una herramienta ‘de pago’) ha sido entrenado con varias fuentes especialmente relacionadas con malware. Este sistema es capaz de generar texto aparentemente humano (mucho más aparentemente humano que el de ChatGPT aún) según los inputs que recibe. De este modo, lo que hasta ahora era un claro indicador de que un email era falso: fallos de gramática, traducciones de dudosa calidad, palabras mal escritas, etc., pasa a ser verdaderamente convincente y puede inducir al incauto usuario (que en este caso puede incluso ser un director financiero) a caer en la trampa.

“Combatir la inteligencia artificial con inteligencia artificial es prácticamente una obligación para las empresas en este nuevo contexto. Y la regulación internacional juega un papel crucial. Debe poner puertas a este enorme campo para controlar las malas hierbas y permitir el florecimiento de los hermosos avances que estamos aún por ver”

Precisamente este es su principal uso hasta la fecha: la creación de emails falsos realmente convincentes destinados a ataques BEC (business email compromise). Es decir, una especie de phishing a nivel empresarial. Y, como su contraparte ‘bondadosa’, es tan fácil de usar que hasta malhechores sin experiencia pueden usarlo para lanzar ataques de phishing masivos en minutos, altamente personalizados y con una infinidad de variantes que nada tienen que ver con la imaginación, sino con la velocidad de procesamiento (pueden ser diseñados por laIA en segundos).

También hay ya incipientes casos de interfaces que ‘parecen ChatGPT’, o que pretenden ser incluso mejores que el popular conversador inteligente pero que están, en realidad, diseñados para engañar al usuario y capturar información sensible o acceder a su sistema.

Con todo ello, claro, no nos queda más remedio que adaptarnos y aceptar que hemos entrado, también, en la era de las nuevas defensas. Porque sólo un sistema igual de rápido podrá descubrir, detectar y bloquear los agujeros de seguridad que se crean a una velocidad que nunca hasta ahora habíamos visto. Mejor aún, ser capaz de anticiparlos, aunque para ello, antes tendría que ‘pensar que existen’. “Combatir la inteligencia artificial con inteligencia artificial es prácticamente una obligación para las empresas en este nuevo contexto. Y por supuesto, la regulación internacional juega aquí un papel crucial: debe poner puertas a este enorme campo para controlar las malas hierbas y permitir el florecimiento de los hermosos avances que estamos aún por ver”, explica Lambert.

No causar daño a humanos o permitir que lo sufran por su inacción; obedecer siempre las órdenes dadas por un humano y proteger su existencia, estas dos, siempre que no entren en conflicto con la primera. Las leyes de la robótica de Asimov, que datan de los años 40 del siglo XX, siguen muy vigentes porque, ¿qué es la IA sino el cerebro dentro del robot?

Los organismos de vigilancia y administración lo tienen claro, así que las toman como base. Ya el Parlamento Europeo ha propuesto seis principios de actuación, aún en estudio por parte de la Comisión, para regular el impacto de la robótica y la inteligencia artificial en el entorno empresarial, laboral y social. Como veremos, algunas de ellas prestadas del mítico autor. A saber:

Botón de apagado: los robots deberán tener un interruptor de emergencia porque el riesgo de que algo salga mal no es nulo.

No podrán hacer daño a los humanos: El objetivo de esta tecnología es ayudar y proteger, en ningún caso causar perjuicio.

Estarán prohibidas las relaciones emocionales con los robots: En el cine y la literatura ya se plantean casos en los que un humano se enamora o se vincula emocionalmente con un sistema artificial, pero ellos, en ningún caso, pueden sentir afecto, por lo que tratan de dejarlo claro.

Seguro obligatorio: Dependiendo de su naturaleza y sus usos, los robots, inteligentes o no, podrían causar daños a bienes materiales o a personas por un mal funcionamiento, así que la entidad propietaria tendrá que hacerse responsable.

Derechos y obligaciones: Todavía no está muy claro si tendrán los primeros -el debate moral de si pueden o no considerarse ‘personas’ está aún candente-, pero sin duda deberán tener los segundos, como esta lista de leyes o normas ya lo indica.

Contribuir a la hacienda pública: Si realizan trabajos que hasta hoy realizan personas, es posible que acaben ganando dinero con ellos y, por tanto, las máquinas (o sus propietarios en su nombre) deberán tributar en consecuencia. Este punto es clave para paliar el problema social y el potencial desempleo que causará esta revolución del mercado laboral.

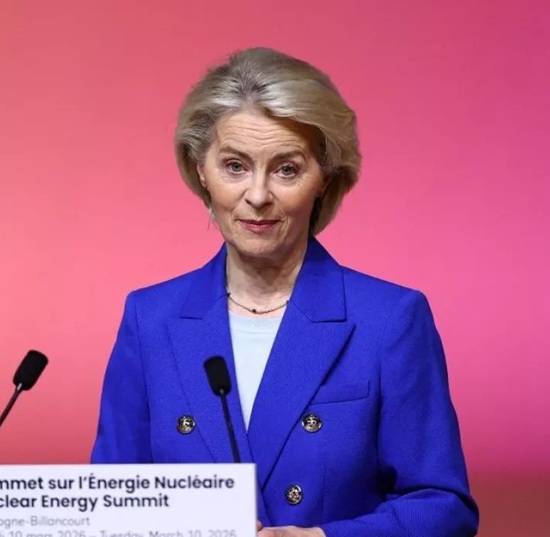

En Estados Unidos también están sentando las bases de un futuro en el que inteligencias artificiales y humanos convivamos. Ha empezado por solicitar el compromiso de las grandes tecnológicas que están trabajando en este tipo de desarrollos -Amazon, Google, Microsoft, Meta y OpenAI- para garantizar la seguridad. “Algo bastante etéreo de momento, pero que al menos nos recuerda, a los expertos en ciberseguridad, que la carrera por la innovación es hoy más rápida que nunca”, concluye Lambert.